Chmura Publiczna, to trend który drzwiami i oknami wdziera się do naszego świata. Dla jednych jest to kierunek, którym chcą podążać dla innych to jeszcze niezbadany grunt, a dla kolejnych to koszmar spędzający sen z powiek. Jeśli w Twojej firmie myślicie o chmurze publicznej, to mam nadzieję, że ten wpis pomoże Ci podjąć decyzję o wyborze usługodawcy.

Dostawcy tych rozwiązań z kwartału na kwartał odnotowywują coraz większe dochody. W ostatnim raporcie za Q1 2016, AWS zanotował wzrost dochodów o 64% względem tego z ubiegłego roku. Z ankiety JP Morgan przeprowadzonej wśród CIO wynika, że obecnie 16,2% workloadu w dużych firmach realizowanych jest przez zasoby chmury publicznej, a w ciągu kolejnych 5 lat osiągnie poziom 41,3%. To pokazuje, że nie jest to przejściowy kierunek ale coś w rodzaju ewolucji, która zmienia wszystkie reguły gry. W szczególności to w jaki sposób działać będą firmy, jak zmieni się ich sprawność biznesowa pod kątem np. rozwijania czy dostarczania nowych usług, oraz to w jaki sposób będą liczyć koszty, jak będą wyglądały i czym zajmowały działy IT.

Dostawcy tych rozwiązań z kwartału na kwartał odnotowywują coraz większe dochody. W ostatnim raporcie za Q1 2016, AWS zanotował wzrost dochodów o 64% względem tego z ubiegłego roku. Z ankiety JP Morgan przeprowadzonej wśród CIO wynika, że obecnie 16,2% workloadu w dużych firmach realizowanych jest przez zasoby chmury publicznej, a w ciągu kolejnych 5 lat osiągnie poziom 41,3%. To pokazuje, że nie jest to przejściowy kierunek ale coś w rodzaju ewolucji, która zmienia wszystkie reguły gry. W szczególności to w jaki sposób działać będą firmy, jak zmieni się ich sprawność biznesowa pod kątem np. rozwijania czy dostarczania nowych usług, oraz to w jaki sposób będą liczyć koszty, jak będą wyglądały i czym zajmowały działy IT.

Kiedy już jednak Twoja firma zdecyduje się na uruchomienie czy przeniesienie jakichś aplikacji do chmury, bez względu na to czy będzie to kierunek hybrydowy czy tylko chmura publiczna, to nadal kwestią pozostaje gdzie to zrobić. Jest to ogólnie temat rzeka odnośnie tego w jakich sposób zabrać się za przeniesienie czy budowanie aplikacji w chmurze (polecam wcześniejszy artykuł “Cloud Native Applications”). Napewno jednym z ważniejszych aspektów jest wybór dostawcy. Na rynku jest wiele firm oferujących usługi Cloud. Jedni z nich dostarczają kompleksowy zestaw usług inni skupiają się na pojedynczych bądź kilku usługach (np. Software as a Service, Backup as a Service). Poniżej postaram się przedstawić wam moją opinię nt. tego dlaczego warto pomyśleć o dostawcach oferujących kompleksowe rozwiązania i rozważyć czołową trójkę, czyli Amazon Web Services, Microsoft Azure czy Google Cloud.

Kompleksowa oferta rozwiązań IaaS, PaaS, SaaS itp.Wybór dostawcy oferującego tylko IaaS nie rozwiązuje wszystkich kwestii. Owszem następuje tu znaczna redukcja kosztów CAPEX ponieważ nie trzeba już inwestować w zakup sprzętu jak serwery, storage, sieć itp. Jednak nie dzieje się tak samo w przypadku kosztów OPEX, bo czy czy środowisko ma np. 100 wirtualnych maszyn we własnym DC czy u dostawcy IaaS, to nadal ponosimy koszty utrzymaniowe/implementacyjne tych 100 maszyn. Dlatego w tym obszarze zysk jest tylko częściowy. Tylko koszty związane z utrzymaniem, rozwijaniem infrastruktury sprzętowej spadają na dostawce. Zatem jeśli Twoim celem jest obniżenie kosztów utrzymania, potrzebujesz czegoś więcej niż sam IaaS.

Wszystko as a Service. To kolejny plus dla czołowej trójki, która non stop rozwijają swoje produkty/usługi i dodają kolejne. Wykorzystanie gotowych rozwiązań jak np. baza danych as a Service, pozwala obniżyć koszty OPEX jeszcze bardziej. Utrzymując bazy w sposób klasyczny czyli na serwerach wirtualnych nadal trzeba się troszczyć o te maszyny wirtualne ich konfiguracje, patche, skalowanie czy replikację samej bazy i backupy. Wykorzystując bazę w modelu usługowym (np. AWS RDS, Azure SQL DB), spychamy na dostawca wszystkie te kwestie, a nasza praca sprowadza się zazwyczaj do wybrania rodzaju bazy, jej “mocy”, wariantu replikacji i okienka backupowego. Dodatkowo bardzo często użycie czegoś w modelu usługi może się okazać, że jest sporo tańsze. Widziałem przypadek, kiedy przeniesienie baz hostowanych na maszynach wirtualnych na bazę w modelu usługi (w ramach tego samego dostawcy chmury) zredukowało koszty tego rozwiązania o ponad 90%.

Skalowalność, to kolejne “ZA”. Wybierając dużego dostawce mamy “Prawie” (przed duże P) nieograniczony dostęp do zasobów. Tak naprawdę chodzi oto, że dość łatwo i szybko możemy powoływać nowe zasoby, albo skalować obecne środowiska (np. podczas kampanii promocyjno-sprzedażowej) przy wykorzystaniu gotowych rozwiązań (np. AWS Auto Scaling Group). A co za tym stoi? Internety mówią, że w każdym DC AWS jest około 50 tyś serwerów fizycznych. Każdy region ma 2+ DC. Podobnie w MS Azure którego tempo rozwoju jest jeszcze szybsze. Zatem jeśli nie chcesz długo czekać na zasoby, bądź Twoim celem jest np. skrócenie czasu dostarczenia nowego rozwiązania dla biznesu, to wybierając dużego dostawce jesteś na dobrej drodze.

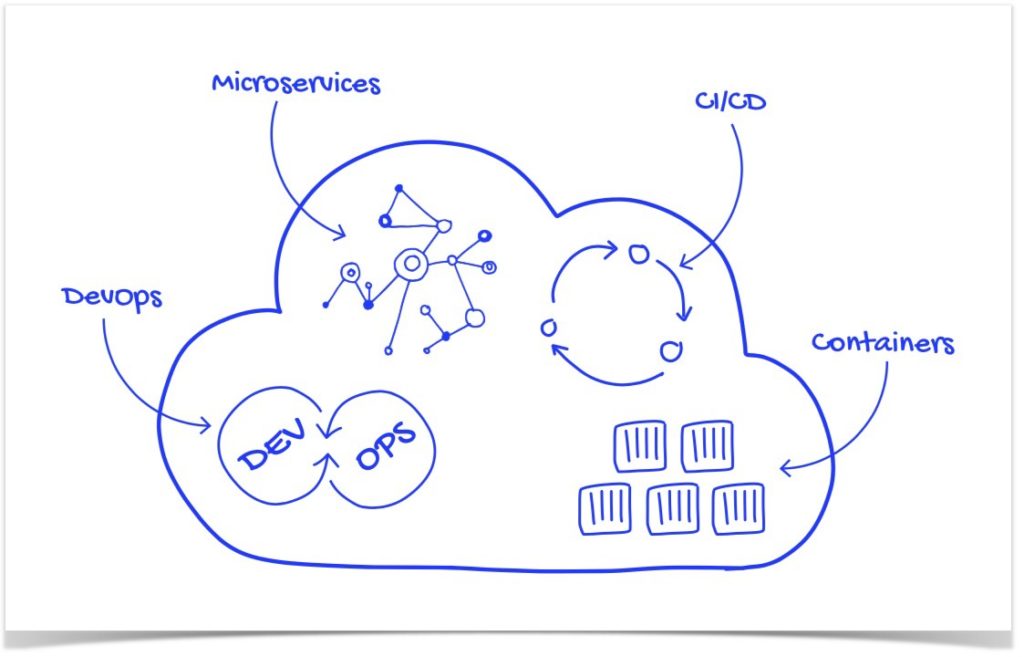

Nowe metody wymagają nowych narzędzi. Jeśli w Twojej firmie hasła jak np. DevOps, Agile czy Continuous Delivery są znane, a nawet stosowane tzn, że potrzebujesz takich narzędzi jak np. Azure Resource Manager, AWS Cloudformation, Azure AppService czy AWS Elastic Beanstalk itp. Dzięki temu będziesz w stanie dużo szybciej dowozić nowe rozwiązania czy funkcjonalności dla biznesu. Jeśli zatem wyznacznikiem sukcesu, jest dla Ciebie jak najkrótszy “time to market” nowych funkcji czy aplikacji, to decydując się na któregoś ze wspomnianych dostawców masz już gotowe narzędzia mogące pomóc w realizacji przyjętych założeń.

Network Security w pakiecie. Z racji, że usługi sieciowe rownież dostarczone są w modelu as a Service, w związku z tym istnieją pewne elementy o które nie musimy się już martwić. W ramach usługi otrzymujemy wbudowaną ochronę przed np. DDoS, IP Spoofing, Man in the Middle, Port Scanning. No i poza tym otrzymujemy gotowe narzędzie pomagające podnieść bezpieczeństwo całej infrastruktury. To wszystko na koniec przekłada się na oszczędność czasu, pieniędzy i wysokie bezpieczeństwo.

Wysoka dostępność. To kolejny bardzo mocny punkt “dużej trójki”. Tworzą architektury które gwarantują wysokie SLA dostępności usług. Przyglądając się przykładom np. Azure Storage serwis gwarantuje dostępność danych na poziomie 99,99% (dla RA-GRS), dodatkowo dane przechowywane są w kilku replikach i np dla danych przechowywanych w AWS S3 (Simple Storage Service) data durability jest określone na poziomie 99,9999999%. Z innych przykładów Route 53 (usługa DNS w AWS) gwarantuje dostępność na poziomie 100%. Dodatkowo z racji ilości centrów danych i regionów możemy budować systemy wysoko dostępne w różnych wariantach jak np. w ramach jednego regionu ale w dwóch Data Center, albo idąc krok dalej z dodatkową replikacją do innego regionu. Jeśli zatem Twoim celem jest np. zwiększenie dostępności swojej aplikacji, warto przyjrzeć się co oferują AWS, Azure i jak to wykorzystać.

Nowe trendy, IoT, Big Data itp. Coraz więcej firm zaczyna, bądź ma już doświadczenia z zaawansowaną analityką danych Big Data, ponieważ to potężne narzędzie wspomagające biznes. Przykładem może być Netflix i ich znany serial “House of Cards”, do sukcesu którego przyczyniła się właśnie zaawansowana analityka danych. Netflix zbiera bardzo dużo informacji nt. tego co robimy na ich portalu, co oglądamy, jak długo, kiedy itp. To pomaga budować im rekomendację dla widza, czyli to co widzimy w zakładce “polecane”. Dane mówią, że 75% tego co ludzie oglądają na Netflix pochodzi z tego co zostało im zarekomendowane. Dlatego nie dziwi fakt, że duzi dostawcy od jakiegoś czasu oferują gotowe rozwiązania dla BigData, IoT itp.

Bo duzi gracze, grają razem. Tutaj mam na myśli firmy produkujące komercyjne rozwiązania. Model hybrydowy pomijając fakt czy uważany za przejściowy czy docelowy dla branży IT z pewnością będzie tym co przez długie lata będzie widoczne na rynku. Dlatego nie dziwi fakt, że producenci sprzętu i różnych rozwiązań do tej pory dydykowanych on-premis (Cisco, VMware, HP i inni) stawiają właśnie na model hybrydowy i starają się grać razem z dostawcami chmur publicznych. Dzięki temu klienci, którzy myślą o hybrydzie powinny znów popatrzyć na dużych dostawców Public Cloud ponieważ przyniesie im to wiele korzyści, łatwiejszą implementację i powiązanie świata prywatnego z publicznym.

Koszty, koszty koszty! To kolejny aspekt, który warto wziąć pod uwagę. Co chwilę przeczytać można o kolejnych obniżkach cen różnych usług. Dzięki temu, że duzi dostawcy są w stanie np. sami produkować serwery czy inne komponenty, sprawia, że ich koszty też są niższe. Większość rozwiązań budowanych jest właśnie na własnych produktach, bądź projektach opartych o open-source, co wyklucza płacenie wagonów $$$ za np. same licencje. Patrząc na fakt w jaki sposób budowane są modele cenowe widać, że dzięki dążeniu do jak największej utylizacji infrastruktury sprzętowej, można obniżać koszty. Widać to na przykładzie modeli “Reserved” i “Spot” w AWS, które stworzone są tak aby nakręcać jak największą utylizację infrastruktury. Oczywiście hasło Koszty ma wiele definicji, bo patrząc z punktu widzenia organizacji, dla każdego mogą być innym wyznacznikiem. Dla jednych może być to obniżenie kosztów CAPEX, lub kosztów OPEX związanych z utrzymaniem infrastruktury, a dla innych może to być jak najkrótszy “time to market” wdrożenia nowej usługi biznesowej.

Przetwarzanie danych w ramach EOG (Europejski Obszar Gospodarczy) nie jest barierą. To kolejna bardzo ważna kwestia, który pozwala nam na wykorzystanie usług dużych dostawców, którzy mają swoje ośrodki również na terenie Europy (AWS, MS Azure, Google Cloud). Na szczęście coraz więcej ludzi jest tego świadomych, a to między innymi dzięki takim osobom jak np. Agata Kowalska z kancelarii Chabasiewicz Kowalska i Partnerzy, która pojawia się na różnych konferencjach branży IT i pomaga klientom rozwiać wątpliwości. Temat nie jest prosty, ale na szczęście coraz więcej firm nie tylko z branży IT zgłębia tematykę Cloud z różnych aspektów, tych prawnych również.

Podsumowanie

Jeśli Twoja firma podjęła już decyzję o tym aby zacząć wykorzystywać rozwiązania chmury publicznej, to mam nadzieję, że to zestawienie zachęci Cię do przyjrzenia się temu co oferuje czołowa trójka. Przynajmniej do zastanowienia się w jaki sposób ich rozwiązania mogą wspomóc Twoją firmę w realizacji strategii biznesowych. Te dziesięć punktów wybrałem spośród większej ilości skupiając się na wartości dodanej dla biznesu. Od pewnego już czasu obserwuję, że coraz więcej firm patrząc na chmurę publiczną na pierwszym miejscu nie stawiają już redukcji kosztów CAPEX czy OPEX, ale właśnie jako miernik sukcesu stawiają sobie realizację pewnych założeń biznesowych.